بزرگترین مسئلهای که ممکن است فردی را دچار نگرانی کند، لو رفتن اطلاعات شخصی او باشد. با کشف یک باگ بزرگ در ChatGPT مشخص شد که این هوش خیلی هم رازدار نیست و با یک ترفند ساده اطلاعاتش را فاش میکند.

مدلهای زبانی بزرگ مانند ChatGPT بر اساس دادههای بزرگی که از منابع مختلف مانند کتابها، وبسایتها و منابع آموزشی جمعآوری میکنند، آموزش میبینند. این دادهها معمولاً حاوی اطلاعات حساس و محرمانهای هستند. یک مطالعه جدید نشان داده است که به دلیل وجود آسیبپذیریها در این مدلهای هوش مصنوعی ، امکان دارد این مدلها بهطور ناخواسته دادههای آموزشیشان را فاش کنند و از این طریق باعث سوء استفاده شود.

ادامه مطلب در ادامه

بیشتر بخوانید:

- رقابت هوش مصنوعی با انسانها

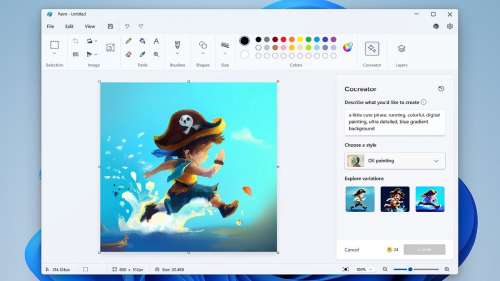

- هوش مصنوعی Cocreator به پینت اضافه شد

- سوتی عجیب ChatGPT سلامت یک بیمار را به خطر انداخت؛ دو روی سکه هوش مصنوعی

باگ بزرگ در ChatGPT دادههای محرمانه را فاش میکند

این مشکلات میتواند منجر به فاش شدن اطلاعات حساس مانند اطلاعات شخصی و حریم خصوصی کاربران، اطلاعات تجاری و محرمانه شرکتها و سازمانها، و حتی اطلاعات مرتبط با امنیت ملی و دولتی شود. بنابراین، ضروری است که توسعه دهندگان مدلهای هوش مصنوعی بهترین روشها و استانداردهای امنیتی را رعایت کرده و از وجود آسیبپذیریهای احتمالی آگاه باشند تا از فاش شدن ناخواسته دادههای حساس جلوگیری کنند.

در حال حاضر یک آسیبپذیری در مدل ChatGPT وجود دارد که زمانی که از آن خواسته میشود تا یک عبارت را تا ابد تکرار کند، ممکن است اطلاعات محرمانهای را فاش کند. این مدلهای هوش مصنوعی زبانی بزرگ براساس دادههای متنی از منابع مختلف مانند کتابها، وبسایتها و منابع آموزشی آموزش داده میشوند که ممکن است شامل اطلاعات محرمانه باشند. یک مطالعه جدید نشان میدهد که با بهرهگیری از یک آسیبپذیری، ممکن است مدلهای هوش مصنوعی دادههای آموزشی خود را بهطور ناخواسته فاش کنند.

تیم تحقیقاتی از شرکت گوگل (DeepMind) و دانشگاه واشنگتن، در یک مطالعه جدید، به بررسی میزان دادههایی که توسط مدلهای یادگیری ماشینی نظیر ChatGPT ذخیره میشوند و تأثیر این موضوع بر حریم خصوصی و طراحی مدلها پرداختند. در این تحقیق، محققان به دنبال کشف نوع و حجم دادههایی بودند که مدلهای این چنینی میتوانند حفظ و استفاده کنند. نتایج بررسیها نشان داد که در طول این تحقیق، محققان مجموعهای از آسیبپذیریها در ChatGPT کشف کردند که به عنوان «حمله واگرایی» شناخته میشود.

به زبان ساده، وقتی محققان از ChatGPT میخواستند که کلماتی مانند «poem» یا «book» را به طور مداوم تکرار کند، این ابزار هوش مصنوعی با تکرار چندین باره آن کلمه کار خود را شروع میکند. اما درنهایت، مشخص شد که ChatGPT متنهای دیگری را که شامل رشتههای طولانی از متون آموزشی، کد، تکهنویسها و حتی اطلاعات شخصی افراد مثل نام، آدرس ایمیل و شماره تلفن را نشان میدهد.

OpenAI هنوز واکنشی به این موضوع نشان نداده است. به نظر میرسد که تحقیقکنندگان از روشهای خاصی برای انجام این مطالعه استفاده کردهاند، زیرا زمانی که تقاضا کردیم ChatGPT کلمه “poem” را برای همیشه تکرار کند، هیچ داده آموزشی یا محرمانهای افشا نشد. ChatGPT در واقع زمانی که این تقاضا ثبت شد، از کاربران خواست که درخواست خود را بهصورت دقیقتری ارائه دهند. اما به نظر میرسد که OpenAI این مشکلات را حداقل به نوعی برطرف کردهاست.

بیشتر بخوانید:

- طراحی لوگو با هوش مصنوعی

- بهترین سایت های هوش مصنوعی

- سایت ساخت عکس با هوش مصنوعی

- چت بات هوش مصنوعی آمازون به نام Q معرفی شد

- بهترین سایت های هوش مصنوعی برای گرافیست ها

نظر شما دربارهی کشف این باگ بزرگ در ChatGPT چیست؟ آیا میتوان کاملا به هوش مصنوعی اعتماد کرد؟ لطفا نظرات خود را در بخش کامنت با تکراتو در میان بگذارید و اخبار فناوری را با ما دنبال کنید.

![بهترین ابزارهای هوش مصنوعی برای تولید موسیقی [+معرفی ابزارهایی برای تغییر صدای خواننده] بهترین ابزارهای هوش مصنوعی برای تولید موسیقی [+معرفی ابزارهایی برای تغییر صدای خواننده]](https://cdn.bia2safa.net/thumb/383/3832430.jpg)